Risikostufen

Die KI-Verordnung basiert auf einem risikobasierten Regulierungsansatz: Je höher das Risiko einer KI-Anwendung ist, desto strenger ist die Aufsicht.

Wie wahrscheinlich ist es, dass ein gewisser Schaden auftritt?

und

Wie groß ist der Schaden?

Die Verordnung umfasst eine Reihe von Regelungen, die KI-Systeme in verschiedene Risikostufen einteilen, die weiter unten näher erläutert werden. Diese Stufen beeinflussen die Anforderungen, die an die Systeme gestellt werden.

Von den allermeisten KI-Anwendungen gehen keine besonderen Risiken aus. Dazu gehören beispielsweise E-Mail-Spamfilter, personalisierte Produktvorschläge oder Chatbots in der Kundenkommunikation sowie Computerspiele, die KI einsetzen. Für diese Anwendungen gelten keine oder nur sehr geringe Anforderungen wie Transparenzvorgaben.

Es gibt aber auch KI-Anwendungen, von denen Gefahren für Leib und Leben ausgehen oder die europäischen Grundrechte verletzen könnten. Sie unterliegen einer strengen Aufsicht. Dazu gehören z. B. KI-Systeme in der Gesundheits- und Energieversorgung, im Straßen- und Flugverkehr oder solche, die Entscheidungen über Sozialleistungsansprüche oder Kreditwürdigkeiten treffen.

Diese Risikostufen gelten nur für KI-Systeme. Für KI-Modelle mit allgemeinem Verwendungszweck gelten spezielle Anforderungen. Näheres dazu finden Sie hier

Vier Risikostufen

| Inakzeptables Risiko | Verboten Einige KI-Systeme werden als inakzeptabel risikobehaftet eingestuft, da sie gegen EU-Grundrechte verstoßen oder eine deutliche Bedrohung für die Sicherheit und Gesundheit von Menschen darstellen. Daher sind solche KI-Systeme seit dem 2. Februar 2025 in der EU vollständig verboten. Dazu gehören u.a.:

Weiterführende Informationen: hier |

| Hohes Risiko | Konformitätsbewertung erforderlich KI-Systeme mit hohem Risiko bergen die Gefahr, durch Fehlfunktionen oder bei Missbrauch erheblichen Schaden zu verursachen. Deshalb unterliegen sie strengen Vorschriften, um sicherzustellen, dass deren Einsatz keine negativen Auswirkungen auf die Gesundheit und Sicherheit von Personen und deren Grundrechte, oder auf die Umwelt hat. Hierbei werden zwei verschiedene Bereiche von Hochrisiko-KI betrachtet. Beispiele für hochriskante Anwendungen in diesen sind:

|

| Begrenztes Risiko | Transparenzpflichten Für bestimmte KI-Systeme gelten weniger strenge Vorschriften. Hierzu gehören die meisten kommerziellen Anwendungen von KI, wie etwa Chatbots, Empfehlungsalgorithmen oder KI-Systeme zur Erstellung von Text-, Bild- oder Audiomaterial. Von den meisten dieser KI-Systeme geht nur ein geringes Risiko aus. Wenn in Hochrisiko-KI-Systemen diese bestimmten KI-Systeme implementiert werden, gelten die Transparenzpflichten zusätzlich zu den Hochrisiko-Anforderungen. Dennoch müssen Unternehmen sicherstellen, dass diese Systeme transparent und benutzerfreundlich sind, da hier potentiell Risiken hinsichtlich Manipulation oder sogenannter „Deep Fakes“ auftreten können. So müssen Nutzer darüber informiert werden, dass sie mit einer KI und nicht mit einem Menschen interagieren. |

| Minimales bzw. kein Risiko | Keine besonderen Verpflichtungen, freiwillige Verhaltenskodizes sind möglich KI-Systeme mit minimalem Risiko, wie beispielsweise Spam-Filter, sind weitgehend unreguliert, da sie keine signifikanten Risiken für die Gesellschaft oder Einzelpersonen darstellen. Auf freiwilliger Basis wird dennoch empfohlen, dass solche Systeme gewissen Prinzipien für vertrauenswürdige KI folgen, z. B. hinsichtlich Fairness und Transparenz. |

Zusammenhang zwischen KI-Modell (mit allg. Verwendungszweck) und KI-System

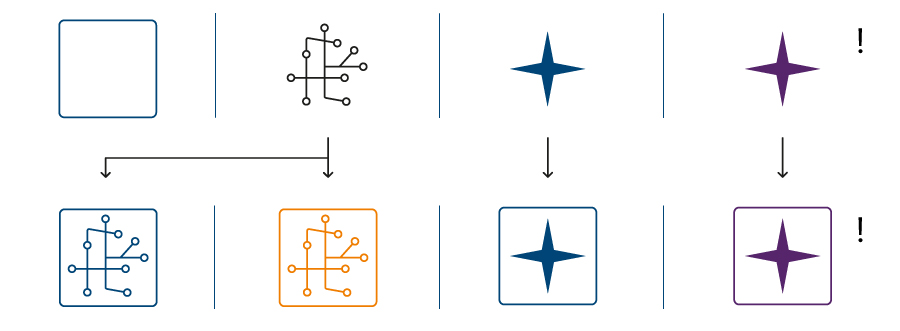

Die nachfolgend abgebildeten Komponenten sind einzelne Basisbestandteile von KI-Systemen bzw. KI-Systeme mit allgemeinem Verwendungszweck (Allzweck-KI-Systemen). Allein stellet ein KI-Modell kein KI-System dar. KI-Modelle können in eine Systemumgebung eingebettet werden, um dann in Kombination die dem Anwendungszweck entsprechenden Funktionalitäten bereitzustellen. Je nach Anwendungszweck ergeben sich daraus dann verschieden eingestufte KI-Systeme.

Die KI-VO definiert die Begriffe des „GPAI-Modells“ bzw. „GPAI-Modells mit systemischem Risiko“ (KI-Modell mit allgemeinem Verwendungszweck bzw. mit systemischem Risiko), sowie des „KI-Systems“ bzw. „KI-Systems mit allgemeinem Verwendungszweck“.

| Umgebende Systemsoftware ohne KI-Modell Bietet z. B. Schnittstellen für die Ein- und Ausgabe von Daten, Funktionen | KI-Modell Die Software-Kernkomponente eines KI-Systems wird durch die KI-Algorithmen und KI-Architektur bestimmt. | GPAI-Modell Die Software-Kernkomponente eines KI-Systems mit allgemeinem Verwendungszweck. Wird durch die KI-Algorithmen und KI-Architektur (meist große Sprachmodelle, LLMs) bestimmt. | GPAI-Modell mit systemischem Risiko Aufgrund seiner Fähigkeiten mit hoher Wirkkraft, stellt dieses Modell die Software-Kernkomponente von KI-Systemen mit allgemeinem Verwendungszweck mit systemischem Risiko dar. |

| |||

KI-System

| Hochrisiko-KI-System Ein KI-System (wie nebenstehend beschrieben), welches aufgrund seines vorgesehenen Anwendungszwecks als Hochrisiko-KI-System eingestuft wird. Für die Details zur Einstufung siehe Hochrisiko-KI. | KI-System mit allgemeinem Verwendungszweck

| KI-System mit allgemeinem Verwendungszweck mit systemischem Risiko Ein KI-System mit allg. Verwendungszweck (wie nebenstehend beschrieben), welches ein GPAI-Modell mit systemischem Risiko integriert. Für weitere Informationen siehe GPAI. |